-

Postów

253 -

Dołączył

-

Ostatnia wizyta

-

Wygrane w rankingu

49

Typ zawartości

Profile

Forum

Wydarzenia

Treść opublikowana przez Spoofy

-

Nice catch. Wygląda na default'owo skonfigurowany CSF+LFD ze skryptem zgłaszającym do AbuseIPDB: https://www.abuseipdb.com/csf . Generalnie partycypowanie w tym projekcie jest dobre, natomiast IMHO powinno się to robić troszkę z głową, np. wycinając zbędne, wrażliwe dane i false positive'y. Generalnie https://www.abuseipdb.com/reporting-policy . W kwestii logowań, sądzę że wątpliwe byłoby przekazywanie jakichś pełnych debug/verbose logów z hasłami gdzieś zewnętrznie, lecz oczywiście pewności nie ma.

-

A widzisz - udostępnij źródełka na githubie to społeczność zforkuje i dopisze tłumaczenie Chętnie przetestuję i być może użyję modułu gdy będzie taka sposobność, dlatego jak chcesz zrobić to "po bożemu" i wstawić sobie gdzieś na marketplace, to wstaw pierw na githuba a dopiszemy co trzeba

-

Cześć, z ciekawości dopytam: Czy dodatek trafił do oficjalnego marketplace'a? Jeżeli nie to dlaczego? Czemu nie udostępnisz źródła na publicznym repozytorium? Czy związany zawodowo jesteś z tworzeniem dodatków?

-

Heh, fajnie obserwować, jak przetartym przeze mnie szlakiem "target" szuka dostępności w DE-CIX. Kto jak kto, ale akurat Ty powinieneś wiedzieć, że gwarancja AntyDDoS do 40 Gbps w standardzie to troszkę za mało na dzisiejsze standardy Cena dodatkowej ochrony do 100 Gbps to dodatkowe 160 euro - cóż, o ile pamiętam to oferty tego typu dalece wykraczają poza budżet dostępny dla tego targetu, także dziwię się, że rozpatrujesz takową. Wiesz również, że bottery posiadają okruchy dużych botnetów i potrafią np. z Miraia bezpośrednio wygenerować ruch rzędu 1Tbps+, no ale przecież AntyDDoS'y to temat rzeka... Jeżeli Holandia to zamiast https://www.greenhousedatacenters.nl/ polecałbym sprawdzony GSL. Ahm i odradzam Rotterdam - straszne miasto, nic do zobaczenia, fajne jedynie na imprezy wieczorem.

-

Cześć, Support JetBackup z tego co pamiętam, (również ze względu na historię w tym produktów) był zawsze na wysokim poziomie. Coś więcej? Jaki panel? Jaka wersja? Jaka metoda (backup/sync czy clone)? W jaki konkretnie sposób ustawiasz backup job? Dopóki nie ustawiasz filtrowania kont, to job jest raczej tworzony domyślnie dla wszystkich kont.

-

Z własnego doświadczenia wiem, że raczej realizacja zamówień publicznych w podobnych przypadkach potrafi być mocno weryfikowana, tym bardziej składniki realizowane na podstawie konkretnego, popularnego, rządowego programu i oddelegowanych zasobów machiny urzędniczej - zatem raczej nie jest to przypadek.

-

Ogólnie - baza, bazie nie równa - zależnie od rodzaju operacji (read vs write), ich ilości, rodzaju konfiguracji (cache?), ewentualnego HA etc. - lecz najważniejsze, jaka to baza i jakie oprogramowanie, co determinuje inne czynniki dotyczące tejże konfiguracji, zarówno pod kątem softu jak i hw. SSD != SSD, zarówno pod kątem bezpieczeństwa jak i szybkości. Tutaj też potrzebny jest konkretny wymóg wydajnościowy i konkretny benchmark, czy założone wartości są spełnione. Dogłębnie znając i stosując LXC w rożnych aspektach, stawianie VM pod bliżej nieokreśloną bazę danych wydaje się marnotrawieniem zasobów. MySQL, MSSQL, ES, Mongo, Influx etc. - większość pójdzie bez problemu w bezpiecznej "przestrzeni nazw" i nie potrzebuje pełnej wirtualizacji. Domyślam się, że wiesz jak działa Proxmox i jest to właściwie niemiecki Debian z pewną filozofią dotyczącą RAID i filesystemów. Istotniejszy jest wykorzystywany filesystem, niż ułożenie macierzy. MySQL i snapshoty - czyli już jakiś konkret - snapshotting wspierany jest przez konkretne filesystemy, tak więc na Twoim miejscu, prędzej pytałbym np. czy LARC/ZVOL z dysków SSD mają znaczenie przy takich operacjach na macierzy HDD. W przypadku ZFS pamięć RAM i jej dostępność powinna zostać ujęta w rozplanowywaniu zasobów. Pan @Poziomeckiświetnie to opisał. Oczywiście pamiętamy o złotej zasadzie: snapshot != backup . CEPH na 10G to tylko do małych operacji. Tak jak wcześniej - tak, snapshotting dostępny jest tylko przy wybranych filesystemach. Zapytałbym, jaki kontroler dysków jest wykorzystywany i w jaki sposób skonfigurowany - ma to zazwyczaj duże znaczenie wydajnościowe pod kątem baz danych. Przy ZFS musisz mieć raw dostęp do dysków lub JBOD/IT mode.

-

[hostline.pl] - informacje nt. usług i oferty hostingu

Spoofy odpowiedział(a) na Hostline.pl temat w Ogłoszenia

Myślę że to wyjaśnia konkretnie. Czemu opieracie się o serwis, który w wielu przypadkach jest zablokowany? Zarówno w popularniejszych jak i na mojej czarnej liście, znajdują się wszystkie adresy i domyślnie serwis check-host.net jest zablokowany, lecz nie ma to absolutnie żadnego wpływu na działanie usług docelowych. Także taka sugestia ode mnie - jeżeli sprawdzacie kwestie webowe, nie korzystajcie z tak oczywistych źródeł/serwisów, które nie dają realnego obrazu sytuacji.- 58 odpowiedzi

-

- 1

-

-

- hosting

- hosting www

- (i 9 więcej)

-

Gorzej że order i tak musisz opłacić z pradawnej (chyba pamiętającej jeszcze manager v3? i oczywiście białej) strony.

-

Oczywiście że tak! Sugerowałbym zatem: https://api.ovh.com/console/#/service/{serviceId}/renew~POST bo panel to jednak wyższy level abstrakcji i myśli francuskiej.

-

Panie, weź Pan wyłącz te darkmode'y, jakieś lokalne css override'y, bo ten angular ichni nie domaga https://github.com/ovh/manager/commit/9c40fcc1a6fe83d8e06874e272d0b4520e0af3e5 Gorzej jak przy renew wyskoczy error, a nie brak tekstu w zmiennej ;)

-

Odkopię, gdyż wpadła mi w ręce analiza raportu BEA-RI. Ciekawa historia o francusko-niemieckiej łodzi EUROPA, bez której ugaszenie i zablokowanie rozprzestrzeniania się pożaru na dalsze budynki, byłoby niemożliwe. (zdjęcie wyszukane na szybko - może nie przedstawiać rzeczywistej jednostki, ale chyba jednak jest to ta jednostka ) Generalnie posiłkując się translatorem, troszkę z przerażeniem czytam wnioski i w związku z tym, chciałbym zapytać - w jaki sposób @OVH spełnia normy i certyfikacje (zaczynając od uptime institute tier-3, kończąc na wszystkich ISO/* etc.) - skoro nie posiada automatycznego systemu przeciwpożarowego? Jak zaznacza autor - raport ma na celu poprawę bezpieczeństwa a nie ocena kto jest winny, lecz raport zawiera takie określenia:

-

Generalnie nomenklatura czasem zdradza pewne kwestie. Jest to też jedna z metod pozyskiwania informacji - standardem jest badanie stref DNS (w tym historycznych) np. pod kątem adresów (często również wewnętrznej) infrastruktury. Inny nie techniczny przykład, to seria faktur. Lokalizacja: 1. «miejsce, w którym znajduje się lub ma się znaleźć jakiś obiekt» 2. «określenie położenia jakiegoś obiektu» 3. «ograniczenie skutków jakiegoś zjawiska do pewnego obszaru» Moim skromnym zdaniem, zarówno szczegółowość jak i nomenklatura, zarówno dla publicznych jak i wewnętrznych zasobów, powinna być opisana, inaczej nawet takie publiczne statusy nie mają większego sensu. Jeżeli tak nie jest, to prawdopodobnie z jakiegoś powodu. Nie ma tutaj "duzo nowych kont" - raczej znani użytkownicy. Jak widać, kontrola pod kątem multikont jest tutaj utrzymana. Widzisz, są takie które do czegoś aspirują albo próbują, są tacy giganci, którzy opisując technologię, nie muszą ubierać czegoś w papkę marketingową i potrafią mieć "SLA 100%" pod kątem usług. Żyjemy w XXI wieku, tutaj wszystko jest szybko, HA, on demand, także może za "Twoich czasów" branża wyglądała inaczej, ale rynek weryfikuje dość szybko. Nom niestety, widać że nie wiesz o czym mówisz. Wszystkie fundusze są w ramach danych programów, także znana jest praktyka w tym zakresie i dysproporcje między rożnymi rodzajami dotacji czy ich źródeł. Założysz działalność, to szybko się o tym przekonasz Może został poszkodowany w wyniku awarii? Czemu nie pomyślałeś o tym, skoro pracowałeś w takim miejscu, hm? Niestety, wiele Twoich słów, rozmija się z m.in. z moim, bardzo krótkim, jak i innych pracowników doświadczeniem w tym zakresie. Jak widać, PR'owo DHosting postanowił wybrać quiz na fanpage'u, zamiast wziąć udział w dyskusji lub odnieść się do wypowiedzi w temacie opinii. Nie wiem czy dalej pracujesz w IT, ale nawet gdy pracowałeś w dhostingu jak twierdzisz, świat znał pewne standardy - przywracanie haseł działa wszędzie tak samo i jest to podstawa w korzystaniu z internetu. Otóż NIE. Nie zezwalamy na multikonta, nigdy, przenigdy, nigdzie - to miejsce jest wolne od tego typu "zagrywek" a takie działanie jest zwyczajnie bez sensu i jak widać, jest to przez nas respektowane. Wolność słowa jest nam dana i zagwarantowana - cieszmy się i korzystajmy z niej, ale mądrze. Każdy z nas reprezentuje tylko a może i aż siebie. Czy oglądając walkę patologii MMA, nie masz wrażenia że świat poszedł w złym kierunku? Widzisz, jeżeli przeżyłeś troszkę w życiu, wiedziałbyś w jaki sposób działa świat i nie zadawałbyś bezsensownych pytań. Dyskusja jest na temat i rządzi się konkretnymi prawami - powinieneś to wiedzieć. NIE. Rootnode to miejsce do wolnej dyskusji na dany temat. Dyskusja potrafi być niekiedy mocną krytyką poirytowanych klientów, ale nie jest to flameboard. Potrafimy celnie i boleśnie obnażyć prawdę, ale nie stosujemy zamordyzmu czy cenzury. Zabawa słowem nie jest proporcjonalna do ich wartości. Sam doceniam kolegę @GrochowskiNinja za humorystyczną formę zaraportowania kolejnej awarii DHosting - w dzisiejszych czasach niepewności i konfliktów, każdemu przyda się odrobina uśmiechu Dokładnie TAK. Pozdrawiam i również miłego! o/

-

Być nie może. Sam miałem ostatnio ten problem i dodawałem tą konfigurację - "u mnie działa", więc zapomniałem gdzie i jak to ustawiłem, ale kurcze tylko te dyrektywy za to odpowiadają. Sprawdź proszę raz jeszcze i ewentualnie daj w custom ten ssl.conf od Dovecot'a zanim przebudujesz config. To nie jest jakiś nowszy Debian? Edit: widzę że podałeś - CentOS 7. Kurcze, na szybko teraz nie pomogę bo nie widzę co jeszcze zmieniałem a te dyrektywy za to odpowiadają. Odezwij się wieczorem na PW to możemy porównać configi. Wiem że też na forum DA o tym pisali i tam była solucja z której sam skorzystałem.

-

Przepraszam, za dużo systemów W jednych RH like zmieniam https://access.redhat.com/articles/3642912 https://access.redhat.com/documentation/en-us/red_hat_enterprise_linux/8/html/considerations_in_adopting_rhel_8/security_considerations-in-adopting-rhel-8 ale w DA ogarnąłem to inaczej. Dla DA sprawdź jednak exim'a: ``` /etc/exim.variables.conf.custom tls_require_ciphers=ECDHE-ECDSA-CHACHA20-POLY1305:ECDHE-RSA-CHACHA20-POLY1305:ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-ECDSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-GCM-SHA384:DHE-RSA-AES128-GCM-SHA256:DHE-RSA-AES256-SHA256:AES128-SHA:AES256-SHA:DES-CBC3-SHA:!DSS:ECDHE-RSA-AES256-SHA:ECDHE-ECDSA-AES256-SHA: ```

-

LXC i limity [Wydzielone z tematu Opinie o nazwa.pl]

Spoofy odpowiedział(a) na Spoofy temat w Bezpieczeństwo

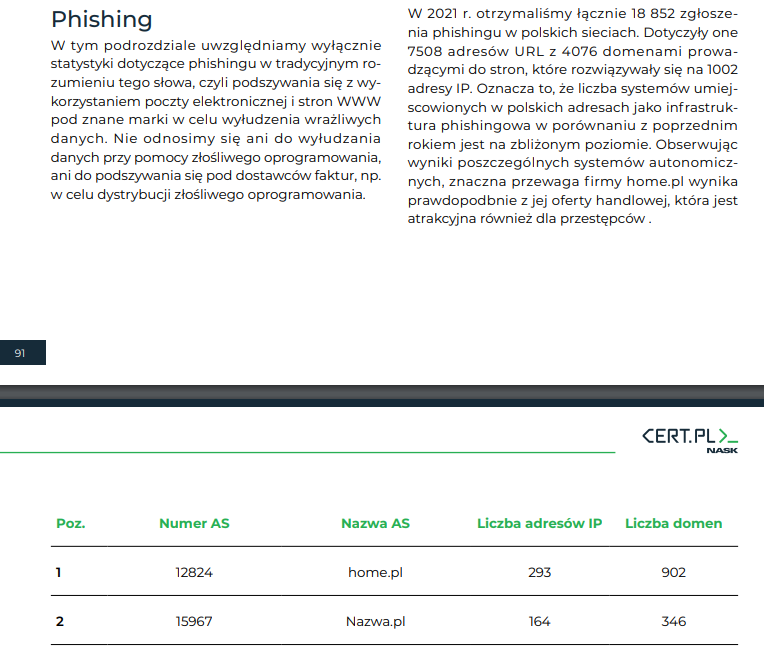

Tak więc, ten "obłędny" raport na stronie 94 ukazuje inne zagadnienie Phising != malware umożliwiający jego rozsiewanie. Wiesz, inne firmy tak hucznie nie reklamują i nie opowiadają o nieomylności i niezawodności swoich rozwiązań, w taki sposób. Nie rozmywajmy się na jakieś wyszukane porównania z innych dziedzin, po prostu skończmy na tym co zostało już napisane. Pewnego piątku powiedziałeś moim zdaniem @itomekpewną techniczną głupotę, ja czując się urażony i "ztriggerowany" się do niej przyczepiłem, uzyskałem informacje na ten temat i tyle. Przepraszam jeżeli Cię uraziłem, dlatego proponuję, proszę - zakończmy tą dyskusję. -

LXC i limity [Wydzielone z tematu Opinie o nazwa.pl]

Spoofy odpowiedział(a) na Spoofy temat w Bezpieczeństwo

Z google też nie potrafisz korzystać, prawda? Tak leniwy jesteś czy serio odrealniony? Proszę, pierwsze z brzegu przykłady: https://www.ovhcloud.com/pl/web-hosting/ https://www.cba.pl/pl/oferta/hosting https://progreso.pl/pl/hosting-hybrydowy Cóż, nie będę mówić o tym że moja własna firma z powodzeniem wdraża takie rozwiązania, no ale serio - wyniesienie usług na osobne node'y w ramach dzielonych klastrów to nie jest rocket science, tym bardziej na podstawie już istniejących rozwiązań. Apropos "CDN'ów" w Polsce, to już było powiedziane dużo na tym forum, jakie realnie ma to znaczenie. Do stackpath'a czy CloudFlare'a to troszkę też wam daleko, a nawet tego typu darmowe usługi dają realne korzyści np. pod kątem SEO czy szybkiego resolvingu za granicą, przy analityce etc. A czemu nie, skoro dałoby się to ładnie poukładać i spiąć na podstawie gotowych rozwiązań, równie wydajnie? Wiesz, większość stosuje tylko dyski NVMe a na nich zewnętrzne macierze ZoL, czy object storage dla konkretnych wymogów - to też jest raczej standard a nie nowość na rynku no ale przy centralnym storage'u raczej przenoszenie ustawień kontenera miedzy node'ami, trwa niewiele więcej niż samo nawiązanie połączenia. Serio mam pokazywać przykłady? Jeżeli klient ma potrzebę gwarancji zasobów - może zakupić usługę gwarantującą ich przydział. Jeżeli klient chce usługi HA z centralnym storage'em rozliczanym per GB, też jest to bajecznie proste, tanie i przystępne, ponieważ to technologia wyznacza standard Cóż, tak mocno nie możesz doszukać się prostych faktów, informacji czy np. mojego CV to nic nie poradzę. To że dominują gotowce, wynikać może z tego że warto z nich korzystać, skoro robią coś dobrze od wielu lat i są znane, hm? Może zamiast skupiać się na aspektach kompletnie nieistotnych, sam wolę skorzystać z takiego gotowca i skupić się na konkretnych wymogach a nie nad developmentem całości Znów mocno wykraczamy poza technikalia, tym razem wkraczając w sferę biznesową. Tutaj kalkulacje są również bajecznie proste - ile developmentu, zmian i rozwoju widać w takich projektach z takimi zasobami a jakimiś internalowymi customami, hm? Uważasz że przykładowo nazwa.pl byłaby w stanie developmentem w jakikolwiek sposób dorównać takiemu projektowi, czy może częściej jest to raczej doganianie standardów kreowanych przez te gotowce? Trywialnych przykładów nie trzeba szukać daleko - obsługa certyfikatów LET w panelu nazwa.pl vs jakikolwiek "gotowiec". Obłędem nazywasz i traktujesz oficjalny, cykliczny raport waszego partnera, powtarzający jak mantrę podstawy bezpieczeństwa internetowego? Sugerujesz że nazwa.pl jest idealnym hostingiem do trzymania takich webshelli i złośliwych skryptów, tym samym promujesz i abrobujesz tego typu występki? Cóż, na samochodach się nie znam, to jest forum o tematyce hostingowej. -

LXC i limity [Wydzielone z tematu Opinie o nazwa.pl]

Spoofy odpowiedział(a) na Spoofy temat w Bezpieczeństwo

Cóż, szukasz widocznie nie tam gdzie potrzeba. Informacji na temat rynku jest dość sporo w internecie. Powtórzę się - do "gwarancji zasobów" istnieją odpowiednie rozwiązania techniczne, w ramach wymaganych potrzeb. Nie rozumiem - dokładnie w taki sam sposób mogą działać gotowe panele, czy usługi ogólnodostępne - zatem "cloud" jest łatwo osiągalny w dzisiejszych czasach, czego dowodzą przykłady tutaj przytaczane. LB ruchu czy efektywne skalowanie i balansowanie jest dość łatwe. Różne hostingi wykorzystują technologię LXC w taki czy inny sposób - niewiedza rynku na temat konkurencji czy też standardów - nieistotne. Nie rozumiem jak dopychanie na wyrost totalnie zbędnych, powielanych procesów w przykładzie dla np. typowej aplikacji webowej PHP, może pomóc w ekologii. Samo zużycie energii przy "gwarancji zasobów" raczej nie jest jej oszczędzaniem. "Dynamicznie przydzielane zasoby" a "ich gwarancja" wśród usług hostingowych czy też web hostingowych jest już dawno zdefiniowana, zaś raz jeszcze powtarzam - technologie konteneryzacji i separacji zostały stworzone do współdzielenia zasobów i ewentualnego ograniczania ich zużycia a nie gwarantowania, co sam przyznajesz. Nie do każdego VPS'a potrzebny jest "admin" - wystarczy odpowiednie rozwiązanie do zarządzania środowiskiem systemowym, automatyzacja. Czasami admin może być potrzebny, lecz znów - jest to oczywiście proporcjonalne do wymagań. Wprowadzanie konkretnej usługi a marketingowe kluczenie na temat jej specyfikacji technicznej to dwie różne rzeczy. Cóż, może "średnio zaawansowany administrator" potrafi poustawiać sobie proste środowisko, lecz ogólnie każda konteneryzacja służy właśnie do prostego skalowania współdzielonymi zasobami i relatywnie łatwo za pomocą wspomnianych rozwiązań stworzyć całkiem przyzwoitą infrastrukturę. Niestety, większość publikacji czy dyskusji z Tobą, kończy się zakrywaniem się "know-how" firmy. Otóż nie, dopytywanie o szczegóły techniczne dotyczące realizacji marketingowych tez w przedstawianej ofercie jest obowiązkiem. Po raz wtóry wyszło szydło z worka, ponieważ technicznie nie jesteś w stanie udowodnić takiego działania, zaś przykłady stosowania takich czy innych rozwiązań z pogranicza "konteneryzacji LXC" dobitnie to ukazują. Po pierwsze - nie wszystkie WAF'y czy IPS'y działają na podstawie sygnatur - zdecydowana większość produktów ogólnodostępnych, w tym urządzeń, które również stosujecie, lecz nie wszystkie. Po drugie, rozumiem że przykładowo przy modsec standardowe reguły OWASP blokują dostęp do `/etc/passwd` ale już nie do innych plików, lecz własnie inne potencjalnie poufne informacje, w tym skrzętnie ukrywane przez Ciebie (tym razem realne) "know-how" firmy, ukazujące pełną konfigurację środowiska systemowego i usług, powinny być blokowane przez reguły WAF. Przeglądanie zawartości wszystkich plików lub danych, newralgicznych ścieżek systemowych jest banalnie proste do zablokowania i przy obecnych standardach, nawet szablony konfiguracyjne, dystrybuowane w popularnych systemach, posiadają takie blokady. Po trzecie - ukazywanie marketingowej a nie technicznej statystyki dotyczącej porównania z sygnaturami jest dość słabe - każdy może się pochwalić ostatnimi próbami blokad wszystkich takich ataków i zliczać, bawić się statystyką, pokazywać kibany, grafany, splunki, sightline'y, fortiosdashboard'y etc. - to nie zmienia faktu, że tych żądań nie zablokował żaden WAF i IPS stosowany przez nazwa.pl, a zdecydowanie powinien. Dlaczego? Otóż dlatego że: po czwarte - nie bez powodu przywołałem kwestię Phishingu i jego rozpowszechniania w ostatnim raporcie CERT, gdyż taki webshell idealnie się do tego nadaje. Nawet "średnio zaawansowany administrator", ba nawet junior powinien wiedzieć o tak poważnym zagrożeniu jakie niesie za sobą taki webshell. Widzisz, każde z szumnie prezentowanych przez Ciebie rozwiązań nazwa.pl kompletnie zawiodło, dlatego że najwyraźniej nie stosujecie podstawowej detekcji potencjalnego malware'u i być może dlatego w oficjalnych statystykach raportu CERT wypadacie tak słabo. Większość, nawet gotowych rozwiązań, np. skanujących w czasie rzeczywistym tego typu plik w pierwszej kolejności umieściłoby taki skrypt w kwarantannie o potencjalnym zagrożeniu, zaś ewentualny false positive przy dobrej praktyce "security-wise", musiałby być zweryfikowany przez właściciela. Nie będę dalej przedstawiał podstaw dotyczących security, ale tutaj naprawdę widać po raz wtóry realne (nie)działanie zabezpieczeń stosowanych w usługach nazwa.pl. Proszę, zajmijcie się tym tematem jak najszybciej, ponieważ przyczyniacie się tym samym do degradacji poziomu bezpieczeństwa polskiej przestrzeni internetowej. Nie będę tego dłużej tłumaczył, proszę o kontakt z CERT, jeżeli czegoś nie rozumiesz. Z mojej strony zakończę dyskusję, gdyż słowne przekomarzanie się mnie nie interesuje a jedynie suche, techniczne fakty, których niestety już tutaj brak, zaś Twoje potwierdzenie w tym zakresie mnie satysfakcjonuje. Oliwa sprawiedliwa, jak to powiadają. -

LXC i limity [Wydzielone z tematu Opinie o nazwa.pl]

Spoofy odpowiedział(a) na Spoofy temat w Bezpieczeństwo

Cóż, dobrze że w końcu wzięliście się za ogarnianie technologii LXC, którą wiele firm w tym ja stosuję od ładnych paru lat produkcyjnie. Niestety, wszystko wskazuje na to że dalej znów perfidnie kluczycie lub nie rozumiecie w jaki sposób ona działa, stąd dyskusja. Sam przecież mówiłeś, że w publikacji będą zawarte wszystkie informacje, a jedyne czego się doszukałem to twierdzenie "gwarantowania zasobów przez 99.9% czasu". Dziękuję bardzo, tak więc to jest clou. Nie ma technicznej gwarancji tych zasobów, poza zapewnieniem. Takie "gwarancje" można sobie wpisać między bajki, bo od "gwarantowania zasobów" są inne, bardziej odpowiednie ku temu technologie, a LXC do tego nie służy, o czym niżej. Zatem taki klaster w praktyce niczym się nie różni od sterty spiętych ze sobą serwerów i przerzucania kont między nimi, co robi każdy kto posiada jakikolwiek resource plan . Czy w trakcie przenoszenia kontenera na inny node jest on niedostępny powodując niedostępność usługi? Czyżby zmiana polityki? Ostatnio nazwa.pl cały czas "zwiększała MW", a teraz nagle tacy "zieloni"? Takie twierdzenia też wydają się śmieszne, dla każdego kto widział datacenter ATM, także absolutnie "zieloni" nie jesteście i raczej długo nie będziecie Błąd - w LVE można uruchomić dosłownie każdy proces w ramach jego limitów. Oczywiście najczęściej LVE nie tyczy się głównego serwera z oczywistych względów - zasoby dla niego powinny być zawsze dostępne Uruchamianie całego serwera www wewnątrz kontenera jest kompletnym marnotrawieniem zasobów - czemu potencjalny klient ma płacić za uruchomiony serwer www Apache, skoro interesuje go procesowanie strony a nie kwestie obsługi sieciowej, hm? Idąc dalej, setup tego typu niczym nie różni się od osobnego serwera VPS w skalowalnym środowisku. Serwery VPS wybierane z uwagi na konkretne potrzeby, dopóki użytkownik ich nie ma to nie widzę absolutnie żadnego sensu, dlaczego klient miałby płacić za zużycie zasobów przez serwer www w ramach własnych zasobów. Init PID 1 w kontenerze jest zły? Z założenia są to odseparowane środowiska i tak działa to w każdej innej metodzie konteneryzacji, w tym we wspomnianym tutaj k8s. Niestety, technologia konteneryzacji powstała właśnie po to, aby współdzielić zasoby, a Ty dalej usilnie próbujesz twierdzić że "99.9%" i przerzucanie między serwerami jest "gwarancją zasobów". No nie, nazwa.pl to nie AWS a takie twierdzenia ponownie ukazują tylko marketingowy bullshit a nie realne zrozumienie i wytłumaczenie stosowanej technologii. Proszę, nie mów mów już o "bezpieczeństwie", bo kompromitacja pod tym względem tutaj osiągnęła już pułap nieosiągalny dla innych firm z top100. Nie pytam nawet ile z głupiego szukania wyszłoby podobnych linków i gdzie jest nieistniejący jak widać WAF nazwa.pl. Ostatni oficjalny raport ukazuje, iż w Polsce nazwa.pl jest na drugim miejscu pod kątem kampanii Phisingowych, tak więc w związku z tym przykładem pytam - czy ta biedna gmina i CERT zostały poinformowane o tym fakcie i czy nazwa.pl ma zamiar coś zrobić z podobnymi, rażącymi przykładami braku odpowiedniego podejścia do bezpieczeństwa? -

LXC i limity [Wydzielone z tematu Opinie o nazwa.pl]

Spoofy odpowiedział(a) na Spoofy temat w Bezpieczeństwo

Wnoszą podstawową wiedzę odnośnie tego, jak działa ograniczanie zasobów za pomocą cgroups. Widzisz, dobrze wiem do czego jest k8s i na pewno nie do hostingu aplikacji PHP w środowisku współdzielonym. Jeżeli stosujesz terminologię k8s, znaczy że albo nie do końca wiesz jak działa i z czego konkretnie korzysta k8s albo nie znasz wymogów środowisk tego typu, gdyż zwyczajnie k8s się do tego nie nadaje i to nie jest ten case. Raczej z doświadczenia stawiałbym coś na wzór https://docs.opennebula.io/6.2/open_cluster_deployment/lxc_node/index.html Szkoda @itomekże nie poinformowałeś o publikacji, tak jak deklarowałeś - niestety, nie obserwuję bloga nazwa.pl, także nie wiem kiedy i co publikujecie. Co do treści samej publikacji, to podobają mi się inspiracja moimi słowami apropos porównania do mieszkania, bloku czy domu usług tego typu W publikacji brakuje technicznych szczegółów, odnośnie tego w jaki sposób jest to realizowane. Nie ma ani słowa o tym, w jaki sposób gwarancja CPU czy pamięci jest zapewniona, zatem raz jeszcze - w jaki sposób procesy uruchamiane w kontenerze mają zagwarantowane zasoby CPU czy pamięci? Czy przykładowo kontener LXC podczas startu alokuje całą gwarantowaną pamięć operacyjną i jest ona niedostępna dla innych kontenerów? "Jeżeli więc widzisz, że hosting oferuje oprogramowanie CPanel + LightSpeed, to możesz być pewny, że nie posiada on funkcjonalności konteneryzacji." Oj, kolejne kłamstwo się szykuje. Czym jest LVE jak nie właśnie metodą "konteneryzacji"? Przemyśl @itomekswoją odpowiedź, gdyż tutaj uderzasz w struny dość dużych graczy i ich technologii -

Możesz postawić cpanel na instancji openstack'a od biedy, ale dalej nijak ma się to do "cloud" + ciekaw jestem jakby wypadało to "wydajnościowo" Let's face it - mówię o tym od dłuższego czasu - zmienia się świat, zmieniają się technologie. Jeżeli masz jakiegoś WordPressa i potrzebujesz PHP to raczej nie jest to aplikacja do skalowania, tak jak w przypadku aplikacji, pisanych z myślą o tym co wymieniłeś Na całe szczęście idzie cała fala SaaS'ów i Jamstack'owych rozwiązań, które troszkę namieszają w tym zakresie, ale dalej - dla zwykłego "shared hostingu www" nijak się to ma. W ogóle - w jaki sposób chciałbyś realizować dostęp IAM? No chyba tylko do bucket'ów w public_html